油貓餅

高級Python工程師

- 公司信息:

- 北京知新樹科技

- 工作經(jīng)驗:

- 2年

- 兼職日薪:

- 500元/8小時

- 兼職時間:

- 下班后

- 周六

- 可工作日遠(yuǎn)程

- 所在區(qū)域:

- 山東

- 全區(qū)

技術(shù)能力

熟練掌握 urllib,Requests,Selenium等爬蟲模塊熟練使用appinum、fillder等工具

熟練使用flask搭建框架,進(jìn)行后端開發(fā)

熟練使用 Python lxml、BeautifulSoup、json模塊以及正則表達(dá)式進(jìn)行數(shù)據(jù)提取熟悉 XPath 語法規(guī)則和各 CSS Selector 的使用熟悉 Scrapy 框架和 scrapy-redis 分布式框架等爬蟲框架熟悉反爬蟲機(jī)制,及反爬蟲方法熟悉django、flask框架數(shù)據(jù)庫技能:

熟練使用 MySQL數(shù)據(jù)庫,了解 MongoDB,Redis 的相關(guān)操作其他技能:

熟悉Javascript語言,掌握HTML/CSS/Javascript/Ajax/JQuery等頁面技術(shù)熟悉 Linux/shell環(huán)境

熟練掌握常用命令行的使用了解 jupyter,Numpy, Pandas,matplotlib,pyecharts 等數(shù)據(jù)分析

熟悉使用Photoshop+Ai作圖軟件

項目經(jīng)驗

項目名稱:通過異步爬蟲爬取HGMD,構(gòu)建mysql數(shù)據(jù)庫

項目描述:

對高通量測序數(shù)據(jù)進(jìn)行數(shù)據(jù)分析時,需要對snp數(shù)據(jù)進(jìn)行相關(guān)性篩選,為此需要構(gòu)建基于mysql的基因突變數(shù)據(jù)庫,對HGMD網(wǎng)站相關(guān)基因突變信息進(jìn)行爬取,爬取內(nèi)容包括基因名,染色體坐標(biāo),突變信息,致病信息等。爬取結(jié)果存儲于mysql。

我的職責(zé)

1,采用asyncio+aiohttp以達(dá)成高并發(fā),異步請求。

2,通過timeout設(shè)置超時重發(fā)機(jī)制,因為HGMD為國外網(wǎng)站,防止因為網(wǎng)絡(luò)卡頓導(dǎo)致頁面抓取不到產(chǎn)生數(shù)據(jù)不全的現(xiàn)象。

3,通過繼承aiohttp.ClientSession類來保存cookie對象,以應(yīng)對基于cookie的反扒策略

4,使用xpath進(jìn)行頁面解析,解析出的數(shù)據(jù)通過PyMysql模塊存儲于mysql數(shù)據(jù)庫中

項目名稱:分布式爬蟲爬取北京市企業(yè)信用信息網(wǎng)

項目描述:

這個項目是通過scrapy-redis搭建分布式爬蟲爬取企業(yè)信用信息網(wǎng)公布欄,爬取列表頁每一項下的子頁獲取數(shù)據(jù)

我的職責(zé)

首先爬取首頁后通過xpath匹配每個的信息塊的span后構(gòu)建請求,并通過scrapy.Request發(fā)送請求,用xpath匹配需要的信息。

同時循環(huán)創(chuàng)建下一頁請求的form表單,通過scrapy.FormRequest發(fā)送POST請求。所有爬取的信息緩存到redis數(shù)據(jù)庫中,

最后通過編寫python腳本將redis數(shù)據(jù)庫中數(shù)據(jù)讀取出來加入mysql數(shù)據(jù)庫。

其他爬取的網(wǎng)站:搜狐新聞、豆瓣、騰訊新聞網(wǎng)、貝殼找房、安居客等等等等。

項目名稱:房源平臺數(shù)據(jù)爬取

項目簡介:搜集全國各地租房、房源及中介信息,并實時監(jiān)測,對數(shù)據(jù)進(jìn)行簡單的數(shù)據(jù)清洗

項目內(nèi)容:

利用 scrapy 框架編寫爬蟲代碼對不同的城市租房信息進(jìn)行爬取

定期檢測爬蟲程序的運行結(jié)果,針對爬蟲程序出現(xiàn)的問題進(jìn)行針對性處理,遇到問題及時更正

負(fù)責(zé)破解網(wǎng)站的反爬手段

項目名稱:公司內(nèi)部清洗系統(tǒng)

項目簡介:尋找清洗規(guī)則,發(fā)現(xiàn)相同邏輯,編寫代碼進(jìn)行清洗

項目內(nèi)容:

使用flask搭建框架,將疾病的清洗規(guī)則導(dǎo)入數(shù)據(jù)庫。

編寫flask視圖界面,測試交互

開發(fā)接口,上傳實例進(jìn)行測試,使用機(jī)器學(xué)習(xí)算法,多線程模式提高程序效率。

案例展示

-

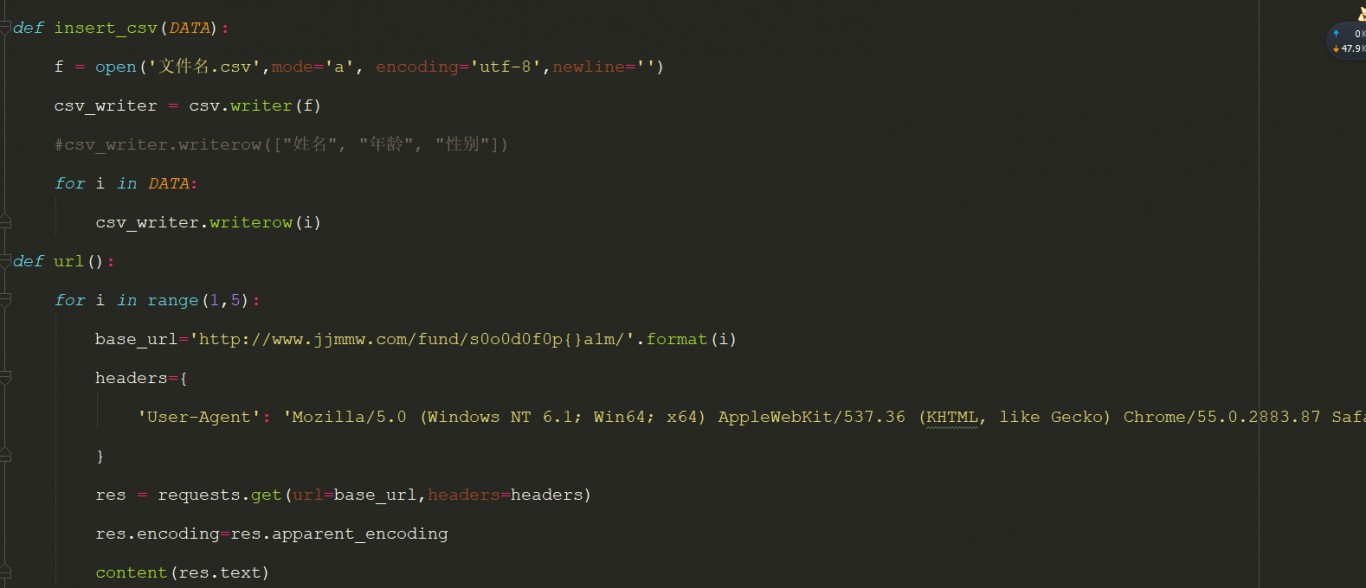

基金采集模塊

爬蟲網(wǎng)站 基金買賣網(wǎng) 使用模塊 Requests、csv、lxml 目的 通過爬蟲獲取數(shù)據(jù)分析股票漲幅 1、分析網(wǎng)站結(jié)構(gòu),找出邏輯規(guī)則 2、編寫xpath規(guī)則 3、寫入數(shù)據(jù)庫

-

跨境產(chǎn)品挖掘系統(tǒng)

該產(chǎn)品與做跨境電商的朋友共同研發(fā),目前尚未發(fā)行。 考慮當(dāng)前跨境電商大環(huán)境下,產(chǎn)品分析是跨境電商中必不可少的一部分。 本產(chǎn)品應(yīng)用了數(shù)據(jù)爬蟲技術(shù),數(shù)據(jù)分析,機(jī)器學(xué)習(xí)算法。

-

跨境產(chǎn)品挖掘系統(tǒng)

該產(chǎn)品與做跨境電商的朋友共同研發(fā),目前尚未發(fā)行。 考慮當(dāng)前跨境電商大環(huán)境下,產(chǎn)品分析是跨境電商中必不可少的一部分。 本產(chǎn)品應(yīng)用了數(shù)據(jù)爬蟲技術(shù),數(shù)據(jù)分析,機(jī)器學(xué)習(xí)算法。

相似人才推薦

-

1000元/天python開發(fā)無概要:精通oodo二次開發(fā),熟悉python三劍客 熟悉pgsql數(shù)據(jù)庫, 熟悉diango, 精通

-

600元/天python工程師武漢卓信智恒數(shù)據(jù)科技有限公司概要:*精通Java基礎(chǔ) *熟練掌握MVC模式開發(fā),及Spring、SpringMVC、Mybatis框

-

1000元/天Python工程師阿里巴巴概要:熟悉H5開發(fā),包括移動端H5,PC端開發(fā),后端Python各種開發(fā),基于Django框架開發(fā)的各種管

-

500元/天python研發(fā)途游概要:python數(shù)據(jù)可視化 python爬蟲 python數(shù)據(jù)可視化python數(shù)據(jù)可視化pytho

-

500元/天python開發(fā)工程師 軟件部門主管西安勺子智能科技有限公司概要:主Python開發(fā),熟練掌握Django、Flask、FastAPI后端框架,熟悉Scrapy爬蟲框

-

1000元/天python數(shù)據(jù)分析深圳中軟國際有限公司概要:熟悉Python,會爬蟲爬取數(shù)據(jù),會用python第三方庫django進(jìn)行web開發(fā),熟悉pytho

-

500元/天python工程師英格科技有限公司概要:精通python基礎(chǔ)模塊 掌握Django及rest framework后端框架 掌握爬蟲相關(guān)

-

500元/天python工程師成都xx科技概要:1、掌握python,具備工程級項目能力,有2年+的python數(shù)據(jù)分析經(jīng)驗,非常熟悉numpy、p